Infinibandで変わるデータセンター内通信(1)

Infinibandは2000年にInfiniBand Trade Associationにより標準化が行われ、現在10Gbpsから40Gbpsの帯域を持つインターフェイス規格として実用段階あります。数多くのスーパーコンピューター・システムで用いられた実績があり、関連するオープンソース開発組織にOpenFabrics Allianceなどが存在します。昨今のこのInfiniband製品の広帯域化と価格下落が著しく、サーバーやストレージ関連業界の中でも注目が集まり、先日国内でもInfiniband DAY[01]というイベントも開催されたばかりです。

IPoIB 10Gbpsの実効性能

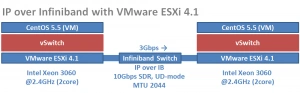

InfinibandインターフェイスにはTCP/IPをサポートするIPoIB(RFC4392)ドライバがあり、各種OS向けに提供されています。 今回はこのIPoIB環境をInfiniband 10Gbps SDR* HCA**のカードを用いて、Intel Xeon 3060 (2core) 2.4GHzの二台のサーバーにVMware ESXi 4.1を導入し仮想マシンとしてCentOS 5.5により実験を行いました。 MTUサイズとしては2044を設定しています。

Fig1. IP over Infiniband with VMware ESXi 4.1

- SDR: (Single Data Rate), **HCA:(Host Channel Adapter)

10Gbpsのトラフィック生成手順

10Gbpsを超えるネットワーク帯域を評価するには、それなりに手順が必要になります。今回、実験にはトラフィック生成ツールであるpktgenを利用しました。pktgenはLinuxのkernel上で動作する高速パケット生成ツールの一つです。以下にその設定方法を例示します。

CentOS# /sbin/modprobe pktgen

CentOS# echo "rem_device_all" > /proc/net/pktgen/kpktgend_0

CentOS# echo "add_device eth0" > /proc/net/pktgen/kpktgend_0

CentOS# echo "max_before_softirq 10000" > /proc/net/pktgen/kpktgend_0

CentOS# echo "count 10000000" > /proc/net/pktgen/eth0

CentOS# echo "clone_skb 1000000" > /proc/net/pktgen/eth0

CentOS# echo "pkt_size 2000" > /proc/net/pktgen/eth0

CentOS# echo "delay 0" > /proc/net/pktgen/eth0

CentOS# echo "dst XXX.XXX.XXX.XXX" > /proc/net/pktgen/eth0

CentOS# echo "dst_mac XX:XX:XX:XX:XX:XX" > /proc/net/pktgen/eth0

CentOS# echo "start" > /proc/net/pktgen/pgctrl

Fig.2 pktgen configuration for IP Traffic generate

今回はInfinibandを用いたデータセンター内通信の可能性について検証を行ってきました。次回は、より広帯域であるInfiniband 40Gbps QDRによる実験結果について皆様と情報共有をしていければと思います。

著者

1996年より特別第二種通信事業者のエンジニアとしてインターネット網整備に従事。システム・コンサルタント,ビジネス・コンサルタント等を経て2010年より現職。トヨタ自動車株式会社を兼業。研究テーマは、デジタルインフラ(DCなど)。